Algoritmes worden steeds meer gebruikt in de wereld van werving en selectie. Maar tegelijk is er altijd veel om ze te doen. Ze kunnen namelijk discriminatie veroorzaken. En als dit het geval is, overtreed je als werkgever de wet. Die verantwoordelijkheid afschuiven op het algoritme of de softwareleverancier? Dat kan dus niet, blijkt uit een nieuwe publicatie van het College voor de Rechten van de Mens.

‘Een uitzendbureau dat enkel studenten werft, maakt indirect onderscheid op leeftijd.’

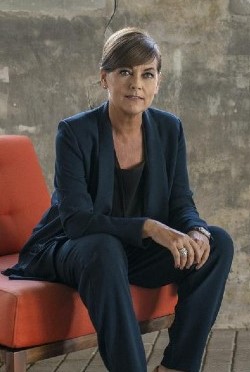

Het onderzoek, getiteld Recruiter of computer?, is een vervolg op een literatuurstudie uit 2020, dat toen verscheen onder de noemer: Als computers je CV beoordelen, wie beoordeelt dan de computers? ‘Algoritmes kunnen zowel direct als indirect verboden onderscheid maken’, concludeert Jacobine Geel, sinds september voorzitter van het College. ‘Als ze bijvoorbeeld selecteren op gronden van leeftijd, geslacht of ras, dan is dat direct verboden onderscheid. Maar ze kunnen ook indirect discrimineren. Een voorbeeld: een uitzendbureau dat alleen maar studenten werft, maakt geen direct onderscheid op leeftijd, maar indirect wel aangezien de meeste studenten jong zijn.’

Het onderzoek, getiteld Recruiter of computer?, is een vervolg op een literatuurstudie uit 2020, dat toen verscheen onder de noemer: Als computers je CV beoordelen, wie beoordeelt dan de computers? ‘Algoritmes kunnen zowel direct als indirect verboden onderscheid maken’, concludeert Jacobine Geel, sinds september voorzitter van het College. ‘Als ze bijvoorbeeld selecteren op gronden van leeftijd, geslacht of ras, dan is dat direct verboden onderscheid. Maar ze kunnen ook indirect discrimineren. Een voorbeeld: een uitzendbureau dat alleen maar studenten werft, maakt geen direct onderscheid op leeftijd, maar indirect wel aangezien de meeste studenten jong zijn.’

Pas extra op bij zelflerend

In het gelijkebehandelingsrecht telt het discriminerende effect. ‘Dat wil zeggen dat het niet uitmaakt of de werkgever opzettelijk discrimineert of niet. Als het algoritme discrimineert, dan is de werkgever verantwoordelijk’, legt Geel uit. ‘Dat is zelfs het geval als een zelflerend algoritme aanvankelijk niet discrimineerde, maar in de loop van de tijd wel verboden onderscheid is gaan maken, zonder dat de werkgever of de algoritmebouwer zich hiervan bewust zijn. Het gaat om het effect in de praktijk.’

Bewuste of onbewuste discriminatie? Dat maakt niet uit.

Of een sollicitant nu door een mens of een computer wordt gediscrimineerd: de uitkomst is hetzelfde. ‘Maar juist omdat het bij een algoritme lastig is om te achterhalen of er sprake was van discriminatie is het van belang dat werkgevers zich bewust zijn van hun verantwoordelijkheid’, waarschuwt Geel. Maar ook arbeidsbemiddelaars zoals uitzendbureaus, moeten ervoor zorgen dat de algoritmes die ze inzetten mensen gelijk behandelen, benadrukt ze. Net als vacaturesites. ‘Ze kunnen de verantwoordelijkheid hiervoor in elk geval niet afschuiven op de opdrachtgever.’

Soms mag het wel

Algoritmes kunnen erg complex worden, staat in het nieuwe onderzoek te lezen. ‘Daardoor is het lastig vast te stellen waarom bepaalde kandidaten zijn afgewezen en is het ook lastiger voor werkgevers om verboden onderscheid te ontdekken of te vermijden. Het kan voor werkgevers een flinke klus zijn om zich voor een algoritme te verantwoorden.’

Het wordt nog ingewikkelder omdat in heel specifieke situaties indirect onderscheid wel is toegestaan.

En het wordt nog ingewikkelder omdat in heel specifieke situaties indirect onderscheid wel is toegestaan. Dit vereist wel een objectieve rechtvaardiging. Zo is het uitsluiten van kandidaten die geen goed Nederlands spreken in bepaalde gevallen wel uitlegbaar. Bijvoorbeeld als de functie vraagt dat de kandidaat veel contact onderhoudt met Nederlandse klanten.

Om te voorkomen dat algoritmes discrimineren is een inzichtelijke, controleerbare en systematische procedure een voorwaarde. Dat is iets waar het College in zijn oordelen over offline sollicitaties overigens ook altijd naar kijkt. Dit betekent onder andere dat de sollicitanten van te voren weten hoe de procedure verloopt, wat de selectiecriteria zijn, waarom sommige mensen worden afgewezen en dat de procedure voor alle kandidaten in principe hetzelfde verloopt. Wordt een procedure niet inzichtelijk, controleerbaar en systematisch uitgevoerd? Dan draagt dit bij aan het vermoeden dat er sprake is van discriminatie.

Minder transparant, eerder vermoeden

Want de hamvraag blijft wie nou het meest discrimineert: de computer of de recruiter? Daar laat het College zich wijselijk niet al te zeer over uit. Al merkt het rapport wel op: ‘Omdat het kenmerkend is aan algoritmes dat ze (nog) minder transparant zijn, wordt in de literatuur gesuggereerd dat er bij algoritmes sneller een vermoeden van verboden onderscheid kan worden aangenomen.’

‘De overwegingen in het hoofd van een recruiter zijn in zekere mate ook een black box.’

Maar ook de menselijke recruiter gaat lang niet altijd vrijuit, beseft het rapport ook. ‘Zo zijn de overwegingen in het hoofd van een recruiter ook in zekere mate een black box.’ Al geldt daarbij wel een verschil: ‘Daarover kun je de recruiter achteraf vragen stellen.’ En bij een algoritme is dat lastiger. ‘Dit is een risico, want hierdoor wordt het verboden onderscheid minder goed zichtbaar’, aldus de onderzoekers.

Inzichtelijk, controleerbaar en systematisch

Als werkgevers kiezen voor de inzet van een algoritme bij werving en selectie, moeten zij dus controleren of er nog steeds een inzichtelijke, controleerbare en systematische procedure wordt gebruikt, stelt het College. ‘Dit betekent onder andere dat de sollicitanten van te voren weten hoe de procedure verloopt en wat de criteria zijn, dat de selectiecriteria duidelijk zijn, dat achteraf duidelijk is volgens welke procedure de selectie plaatsvond, wat de grondslag was voor eventuele afwijzing en dat de procedure voor alle kandidaten in beginsel uniform is verlopen.’

Een werkgever die verboden onderscheid maakt kan financieel aansprakelijk zijn, zelfs als hij niet de bedoeling had te discrimineren.’

En lukt dat niet, dan kun je dus wel eens een probleem hebben. Daar kwam al eens een werkgever achter die werkte met assessments, maar niet kon uitleggen hoe de psychologen verschillende testscores wogen. Resultaat bleek echter dat van de mannen 100% de score ‘geschikt’ haalde, en van de vrouwen maar 1 op de 3.

‘Discriminatie’, oordeelde het College destijds. Want zulke gróte verschillen niet kunnen uitleggen? ‘Dat is voldoende om een vermoeden van indirect onderscheid aan te nemen.’ En dat kan al met al een dure grap worden. ‘Een werkgever die verboden onderscheid maakt kan financieel aansprakelijk zijn, zelfs als de werkgever niet de bedoeling had om te discrimineren.’

Meer weten?

Meer weten?

Lees hier het hele onderzoek. Werkgevers kunnen ook bij het College terecht, bijvoorbeeld om hun eigen handelswijze of beleid te laten toetsen aan de gelijkebehandelingswetgeving. Ook biedt het College een training Selecteren Zonder Voordelen aan.