Is A.I. in recruitment een grote belofte? Maakt het onze werving- en selectieprocedures eindelijk makkelijk, snel en eerlijk? Of is artificial intelligence juist een gevaar dat we eerder moeten beteugelen dan stimuleren? Hoe ver zijn we er eigenlijk al mee? Het is de laatste tijd steeds vaker onderwerp van onderzoek en bespiegeling. En dan vooral waar het selectiebeslissingen betreft. Word je als kandidaat liever afgewezen door een mens of door een computer? Een overzicht van de meest opvallende recente bevindingen.

#1. VU-promovenda: ‘Eerlijkheid geen gegeven’

Ondanks de grote beloftes maakt artificial intelligence selectiebeslissingen niet per definitie eerlijker, zegt VU-promovenda Elmira van den Broek tegen PWnet. Zij onderzocht de eerlijkheid van A.I. in recruitment twee jaar lang bij een grote multinational. ‘Bereid je er maar op voor’, concludeert ze daaruit: ‘Eerlijkheid vergt samenwerking en verloopt in fases.’

Ondanks de grote beloftes maakt artificial intelligence selectiebeslissingen niet per definitie eerlijker, zegt VU-promovenda Elmira van den Broek tegen PWnet. Zij onderzocht de eerlijkheid van A.I. in recruitment twee jaar lang bij een grote multinational. ‘Bereid je er maar op voor’, concludeert ze daaruit: ‘Eerlijkheid vergt samenwerking en verloopt in fases.’

‘Bereid je er maar op voor: eerlijkheid vergt samenwerking en verloopt in fases.’

Van den Broek, verbonden aan het KIN Center for Digital Innovation, schoof aan bij meer dan 100 meetings om te zien hoe de implementatie van een A.I.-gedreven selectietool in praktijk verliep. Daarbij keek ze of de nieuwe tool eerlijkheid in het selectieproces van ruim 10.000 kandidaten zou beïnvloeden. Volgend jaar hoopt ze erop te promoveren. Maar nu al zegt ze: ‘Wat we in ons onderzoek zagen is dat eerlijkheid geen vaststaand gegeven is en door mensen wordt geformuleerd.’

Matchscores niet leidend (meer)

Zo ontdekte ze dat de A.I. af en toe een matchscore berekende die niet strookte met het beeld dat managers hadden bij een kandidaat. Dan stelt de manager meteen de eerlijkheid van het algoritme ter discussie en worden de selectiecriteria of de gewichten ervan heronderhandeld tussen de verschillende partijen. ‘Dat zagen we meerdere keren gebeuren nadat de A.I. werd geïmplementeerd.’

‘Je wilt niet allemaal dezelfde soort supermensen aantrekken.’

Uiteindelijk leidde dat ertoe dat de matchscores nu niet meer leidend zijn bij het onderzochte bedrijf, vertelt ze. ‘Ze zijn nu meer een bron van extra informatie. Individuele succescriteria zijn belangrijk, maar ook of je als kandidaat in een divers team past. Je wilt niet allemaal dezelfde soort supermensen aantrekken. HR weet dat, en kan zich op deze wijze krachtig positioneren bij de introductie van nieuwe technologie.’

#2. Noreena Hertz: ‘Een vervreemdende ervaring’

Een tweede opvallende bijdrage over A.I. in recruitment kwam van de bekende auteur, econoom en activiste Noreena Hertz. In haar recente boek The Lonely Century (De eenzame eeuw) schetst ze een somber en dystopisch beeld van wat ze als kandidaat (onder pseudoniem) meemaakte toen ze niet door een mens, maar door een computer werd geïnterviewd. ‘Zulke algoritmische pre-hire assessments, zoals ze genoemd worden, zijn nu al een miljardenbusiness en worden waarschijnlijk een vaste waarde voor selectiebeslissingen.’

Een tweede opvallende bijdrage over A.I. in recruitment kwam van de bekende auteur, econoom en activiste Noreena Hertz. In haar recente boek The Lonely Century (De eenzame eeuw) schetst ze een somber en dystopisch beeld van wat ze als kandidaat (onder pseudoniem) meemaakte toen ze niet door een mens, maar door een computer werd geïnterviewd. ‘Zulke algoritmische pre-hire assessments, zoals ze genoemd worden, zijn nu al een miljardenbusiness en worden waarschijnlijk een vaste waarde voor selectiebeslissingen.’

‘Voor bedrijven die elk jaar ruim 100.000 sollicitanten krijgen, scheelt dit waarschijnlijk veel tijd.’

Maar zelf bewaart ze geen fijne herinneringen aan een organisatie als HireVue. ‘De technologie “leest” kandidaten door hun toon, taalgebruik, en gezichtsuitdrukkingen te analyseren op meer dan 25.000 datapunten, en de resultaten te vergelijken met een “ideale” kandidaat voor de rol.’ Ongetwijfeld kosteneffectief voor selectie op grote schaal, zegt ze, ‘en aangezien grote bedrijven vaak meer dan 100.000 sollicitanten per jaar krijgen, waarschijnlijk ook een grote tijdsbesparing.’

‘Ik voelde me moordslachtoffer’

Maar als kandidaat beschrijft ze de ervaring toch vooral als ‘vervreemdend’. ‘Het feit dat ik mijn lichaam binnen een getekend silhouet moest houden tijdens het interview zorgde ervoor dat ik me niet alleen een slachtoffer van een moord voelde, maar ook dat ik niet mijn authentieke zelf kon zijn. En doordat ik mezelf zag in de hoek van het scherm, voelde ik me zowel acteur als publiek.’ Daar kwam nog eens bij dat bovenin het scherm een klok meeliep. ‘Dat maakte de ervaring nog stressvoller.’

Maar als kandidaat beschrijft ze de ervaring toch vooral als ‘vervreemdend’. ‘Het feit dat ik mijn lichaam binnen een getekend silhouet moest houden tijdens het interview zorgde ervoor dat ik me niet alleen een slachtoffer van een moord voelde, maar ook dat ik niet mijn authentieke zelf kon zijn. En doordat ik mezelf zag in de hoek van het scherm, voelde ik me zowel acteur als publiek.’ Daar kwam nog eens bij dat bovenin het scherm een klok meeliep. ‘Dat maakte de ervaring nog stressvoller.’

‘Ik moest indruk maken op een machine wiens black box-algoritmes ik nooit zou kennen.’

En dan was er geen gespreksgenoot om – menselijk – aan te toetsen of haar antwoorden in de smaak vielen. ‘Ik moest indruk maken op een machine wiens black box-algoritmes ik nooit zou kennen. Welke formule gebruikte het om mij te testen? En was het fair?’ Daar is ze bepaald nog niet zeker van. ‘De uitdaging van machine learning is al om de duidelijke bronnen van bias te erkennen. Maar hoe moet het met de bias in de minder duidelijke, neutraal lijkende datapunten?’

#3. Duits onderzoek: Meer open met hoofddoek?

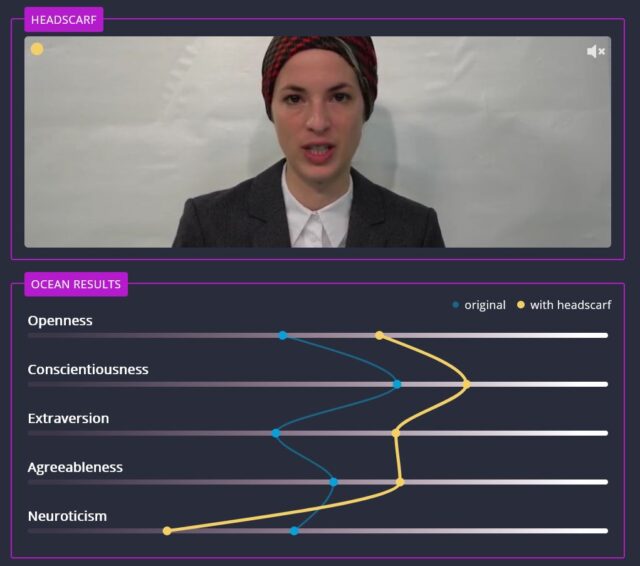

Daarvoor over naar Duitsland, waar een team van publieke omroeporganisatie Bayerischer Rundfunk in de zomer van vorig jaar aan actrice ‘Stefanie’ vroeg een aantal keer te solliciteren via het A.I.-recruitmentsysteem van Retorio, een start-up in München. Haar antwoorden waren daarbij steeds hetzelfde. Alleen: de ene keer had ze een bril op, de andere keer een hoofddoek. Ook andere proeven werden gedaan: de ene keer met een boekenplank in de achtergrond, de andere keer niet. De ene keer met een T-shirt, de andere keer met een blouse en jasje, of met lippenstift, of juist niet.

Hoewel dit niet zou moeten uitmaken voor de uiteindelijke scores van de kandidaat, bleek dat toch vaak wel het geval. Met een hoofddoek scoorde Stefanie bijvoorbeeld ineens veel lager op ‘neuroticisme’ en juist hoger op ‘openheid’. De A.I. neemt dit soort factoren dan ook mee in zijn berekening, antwoordt Retorio. ‘Net als in een normaal sollicitatiegesprek.’ Het algoritme is namelijk getraind om de indruk die mensen maken te beoordelen, aldus de woordvoerder van de start-up.

‘De software zou dit soort informatie eruit moeten filteren, om beter te presteren.’

Maar Uwe Kanning, hoogleraar Business Psychology aan de universiteit van Osnabrück, verbaast zich hier toch over. ‘De software zou dit soort informatie juist eruit moeten filteren, om beter te presteren dan het onderbuikgevoel van mensen die voor zulke invloeden gevoelig zijn.’ Doe je dat niet, dan repliceer je volgens hem alleen maar de stereotypes die mensen toch al hebben. ‘Dat goed uitziende mensen bijvoorbeeld als meer intelligent worden beschouwd, of dat lange mensen betere leiders zouden zijn.’

‘Zo vaak opnemen als je zelf wilt’

In andere experimenten bekeek de omroep of een andere belichting effect had op de score, of een andere stem van de testpersoon. Dat blijkt het geval. Maar, reageert Retorio: ‘De kwaliteit van de video maakt inderdaad verschil, maar dat is ook zo bij normale sollicitatiedocumenten. En sollicitanten kunnen de video zo vaak opnemen als ze zelf willen, anders dan bijvoorbeeld in een normaal sollicitatiegesprek.’

‘Je komt in de problemen op het moment dat je A.I. menselijk gedrag laat beoordelen.’

Toch leiden de grote verschillen in uitkomsten bij de onderzoekers tot een oproep om voorzichtig te zijn met dit soort technieken. Zoals hoogleraar computerwetenschap Katharina Zweig het uitdrukt: ‘In zijn algemeenheid is A.I. fantastisch. Maar je komt in de problemen op het moment dat je A.I. menselijk gedrag laat beoordelen.’

#4. NOA-VU: ‘Vooroordelen soms juist versterkt’

Heb je bij A.I. in recruitment als kandidaat een eerlijke kans? Helaas: niet iedereen, zo concludeert Jacqueline van Breemen, die als data-analist bij NOA-VU hier onderzoek naar deed, onder meer dankzij een bijdrage van de AI x Recruitment Challenge van de NSvP. Belangrijkste uitkomst van haar onderzoek: selectie aan de hand van A.I. versterkt sommige vooroordelen juist, in plaats van dat het ze bestrijdt. ‘Dus als een bepaalde groep nu iets meer succesvol is, voorspelt een A.I.-model dat kandidaten uit eenzelfde groep in de toekomst véél succesvoller zullen zijn.’

‘De belofte om objectiever te selecteren met A.I. wordt nu nog niet waargemaakt.’

In Van Breemens onderzoek werden de kansen op succes voor kandidaten met een Nederlandse achtergrond daardoor te hoog geschat. En de kansen op succes voor kandidaten met een niet-westerse achtergrond juist te laag. Dat betekent volgens de onderzoekster echter niet dat je A.I. nooit zou moeten inzetten in recruitment. Liever pleit ze ervoor de algoritmes ‘uitlegbaar’ te maken. ‘Maar op dit moment is het gebruik van A.I. in recruitment en selectie dus nog te vroeg. De belofte om objectiever te selecteren met A.I. wordt nu nog niet waargemaakt.’

#5. Oxford en Amazon: Toolkit voor meer fairness

De belofte mag misschien nog niet worden waargemaakt, er zijn momenteel ook onderzoekers aan het kijken hoe dat wél kan. Zoals Oxford-hoogleraar Sandra Wachter, die hierover begin 2020 met collega’s Brent Mittelstadt en Chris Russell een paper schreef. Ze keken daarbij naar nieuwe manieren om eventuele discriminatie te ontdekken in A.I. en machine learning-systemen zoals die in recruitment worden gebruikt.

In Oxford werd een test ontwikkeld die zelfstandig discriminatie kan opspeuren.

Ze ontwikkelden daarvoor ook een test, die zelfstandig naar eventuele discriminatie kan zoeken in A.I.-systemen. Die zogenoemde ‘Conditional Demographic Disparity’ (CDD)-methode is recent zelfs overgenomen door Amazon, en geïmplementeerd in hun nieuwe bias toolkit, ‘Amazon SageMaker Clarify’, te gebruiken voor alle klanten van Amazon Web Services. Opvallend, omdat Amazon zelf juist een van de bedrijven is die in het nieuws kwam met een aanvankelijk biased A.I.-tool. ‘Het is dan ook heel bevredigend om te zien dat ons werk nu zo’n impact heeft’, aldus Wachter.

#6. Aptitude: ‘Juist bétere kandidaatervaring’

Voor een ander tegengeluid, ten opzichte van alle scepsis over A.I. in recruitment, kunnen we terecht bij Aptitude Research. Zij stellen namelijk in een nieuw onderzoek (gesponsord door het Australische A.I.-bedrijf PredictiveHire) dat al die algoritmes voor een kandidaat juist een bétere ervaring kunnen opleveren. En wel om vier redenen: A.I. kan feedback verzamelen, en zo steeds beter leren wat kandidaten willen, A.I. kan daarnaast meer diversiteit bereiken door bias uit te sluiten, en door transparant te zijn over je afwegingscriteria kun je kandidaten helpen om jouw overweging te snappen. Bovendien kun je met de inzet van Natural Language Processing élke kandidaat goede, persoonlijke feedback geven, aldus het onderzoek.

Voor een ander tegengeluid, ten opzichte van alle scepsis over A.I. in recruitment, kunnen we terecht bij Aptitude Research. Zij stellen namelijk in een nieuw onderzoek (gesponsord door het Australische A.I.-bedrijf PredictiveHire) dat al die algoritmes voor een kandidaat juist een bétere ervaring kunnen opleveren. En wel om vier redenen: A.I. kan feedback verzamelen, en zo steeds beter leren wat kandidaten willen, A.I. kan daarnaast meer diversiteit bereiken door bias uit te sluiten, en door transparant te zijn over je afwegingscriteria kun je kandidaten helpen om jouw overweging te snappen. Bovendien kun je met de inzet van Natural Language Processing élke kandidaat goede, persoonlijke feedback geven, aldus het onderzoek.

‘Het is een van de grootste misvattingen dat kandidaten geen automatisering zouden willen.’

‘Het is een van de grootste misvattingen dat kandidaten geen automatisering zouden willen, en liever het huidige sollicitatieproces behouden’, reageert Aptitude-CEO en -oprichter Madeline Laurano. ‘Wat kandidaten vooral willen is een eerlijk proces en consistentie in communicatie. En automatisering kan al deze wensen ondersteunen en juist de menselijkheid van de ervaring vergroten.’

Conclusie: vloek of zegen?

Kortom: is A.I. in recruitment nu een vloek of een zegen? Op basis van alle recente onderzoeken is het eindoordeel nog niet te vellen. Ja, de selectiebeslissingen die A.I. ons voorlegt zijn nog zeker niet perfect, zoveel is duidelijk. Maar afgaande op de 50% (!) van de kandidaten die momenteel als ‘niet-succesvol‘ wordt beschouwd, geldt dat natuurlijk net zo goed voor de menselijke selectie. En ook of al die A.I. voor kandidaten nu een vooruitgang of juist een bedreiging is, is het laatste woord vast nog niet gezegd. Alle reden dus om al het onderzoek nog verder voort te zetten. Met andere woorden… wordt vervolgd!