De belangstelling voor ChatGPT kent momenteel bijna geen grenzen. Kijk alleen al bij Werf&. Kwam het onderwerp eind maart al veelvuldig terug bij Bureaurecruitment Live, een dag later kreeg een volle zaal in Breukelen er meer over te weten van mensen als Marcel van der Meer, Han Hendriks en Inge Brattinga. En ook op de bijeenkomst van het exclusieve Recruitment Leaders Network vorige week, met bijdragen van Capgemini’s Marijn Markus en Guido Rademakers, raakten ze er niet over uitgepraat.

Wat vaak opvalt op al die bijeenkomsten: vrijwel iedereen heeft al wel eens met de vorig jaar geïntroduceerde tool geëxperimenteerd. Maar de opbrengsten vallen in de praktijk vaak toch ook nog tegen. Veel meer dan een vacaturetekst die je vervolgens zelf nog mag gaan verbeteren levert het nog zelden op. Hoe betere resultaten te boeken? Dat begint vooral met: leren de goede vragen te stellen. Oftewel: de goede prompts leren maken, een vaardigheid die steeds belangrijker wordt. Wat zijn daarvoor de meest geëigende basistechnieken? We beschrijven er alvast 5:

#1. Geef voorbeelden

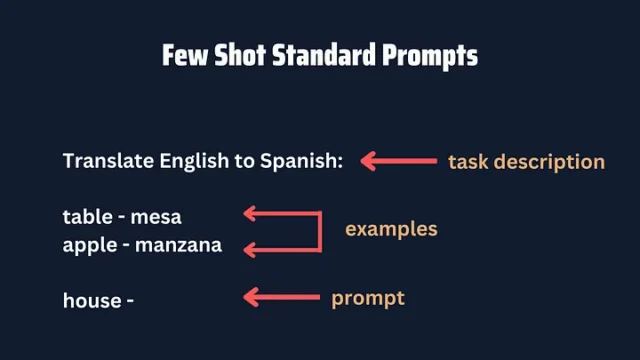

Op Medium schrijft The PyCoach Frank Andrade dat de meeste mensen nog weinig voorbeelden van taken gebruiken in hun prompts. Terwijl de resultaten omhoog schieten als we dat wel doen. Zoals het voorbeeld hieronder laat zien:

Andrade heeft het in dit geval over ‘Few-shot standard prompts‘. Stel: je wilt de luchthavencodes weten van Orlando en Boston. Dan kun je daar direct naar vragen. Maar je kunt ook vragen: ‘Haal de vliegveld-codes uit de volgende tekst. Tekst: “Ik wil van Los Angeles naar Miami”. Luchthavencodes: LAX, MIA. Tekst: “Ik wil van Nashville naar Kansas City”. Luchthavencodes: BNA, MCI. Tekst: “Ik wil van Orlando naar Boston”. Luchthavencodes: …’

‘Als je voorbeelden gebruikt, schieten de resultaten van je prompts omhoog.’

Als je het zo aanpakt, weet je zeker dat je de codes krijgt in het formaat dat je wilt (MCO, BOS, in dit geval). Dit werkt zelfs als je verkeerde codes invoert: het gaat ChatGPT erom het formaat van het gewenste antwoord te leren, niet om de antwoorden zelf.

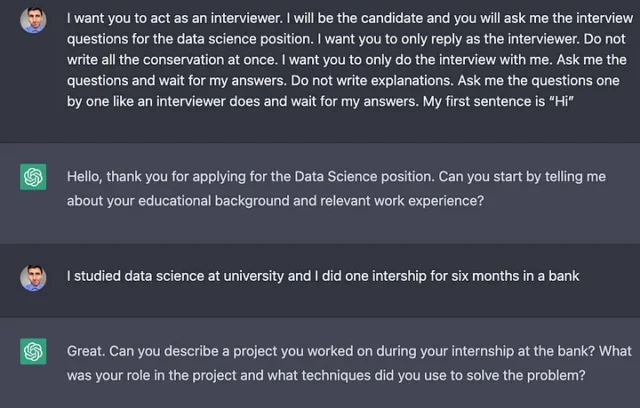

#2. Gebruik rollen

Kom je er niet uit met de standaard-antwoorden van ChatGPT? Vraag hem dan eens om een rol te vervullen. Stel: je wilt als kandidaat oefenen voor een sollicitatiegesprek. Dan kun je ChatGPT vragen zich te gedragen als een hiring manager of recruiter. En door nog meer details toe te voegen, kun je een vrij waarheidsgetrouwe simulatie van een sollicitatie genereren. En zo kan ChatGPT je ook overhoren als je een taal wil leren, of kun je vragen om ChatGPT zich te laten gedragen als bijvoorbeeld een komiek of dokter.

#3. Voeg persoonlijkheid toe

Een aanpalende mogelijkheid om de resultaten van je prompts te verbeteren is persoonlijkheid toevoegen. Door een persoonlijke stijl toe te voegen, kun je teksten met een bepaalde toon, formaliteit of autoriteit genereren. Denk aan een prompt als: ‘Schrijf over [onderwerp] in de stijl van expert [A van de B]’. Je kunt hier ook bijvoeglijke naamwoorden toevoegen. Zoals: gebruik sarcasme, of: schrijf intrigerend, inspirerend of vermakelijk. Je zult zien dat de output elke keer zal verschillen.

Gebruik bijvoeglijke naamwoorden en je zult zien dat de output elke keer zal verschillen.

Een voorbeeld van zo’n prompt: ‘Schrijf een grappig artikel in 500 woorden over waarom A.I. mensen niet zal vervangen. Schrijf in de stijl van een expert met meer dan 10 jaar ervaring. Gebruik humor in de voorbeelden die je noemt.’ Bijkomend voordeel: het wordt hiermee moeilijker voor A.I.-detectors om te achterhalen of de tekst zelf geschreven is, of dat ChatGPT dat heeft gedaan. Je kunt dit ook ‘getrapt‘ doen: door bijvoorbeeld ChatGPT eerst om 5 bijzondere feiten te vragen, en vervolgens te vragen om die feiten te verwerken in een grappig artikel.

#4. Prompt in een keten

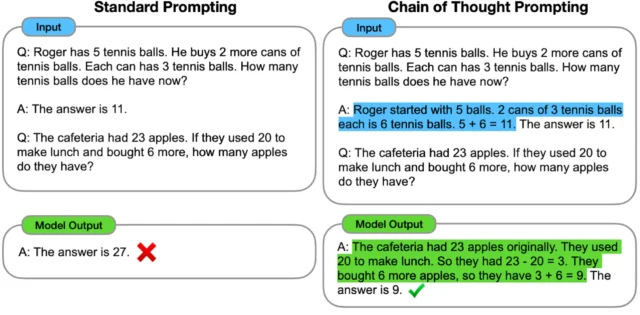

Prompts ‘in een keten’ wijken af van de standaard-prompts doordat ze ChatGPT meehelpen in wat je van hem verwacht en welke redeneertrant je daarbij wil dat hij gebruikt. Dit leidt tot meer accurate resultaten. Ook hier: voorbeelden zijn belangrijk, om ChatGPT op weg te helpen. Zoals onderstaand voorbeeld laat zien:

Doordat je in het tweede model zelf ChatGPT laat zien hoe je aanvankelijke redenering werkt, zal hij het makkelijker hebben om bij de volgende opgave diezelfde redenering te hanteren. Al moet gezegd dat de redeneervaardigheden van ChatGPT-4 alweer zoveel verbeterd zijn, dat dit waarschijnlijk niet veel effect meer zal hebben.

#5. Zero-shot-chain-of-thought

Een bijzondere categorie binnen de hiervoor genoemde categorie prompts is de zogeheten ‘zero-shot-chain-of-thought‘. Hierbij vraag je eenvoudigweg aan ChatGPT om stap voor stap tot het antwoord te komen. Met uiteindelijk betere resultaten.

Conclusie: de vergelijking is al vaker getrokken, maar zie het leren schrijven van goede ChatGPT-prompts vooral als ‘het nieuwe Boolean‘. Ook daarbij gaat hem immers om ogenschijnlijk eenvoudige technieken waarmee je toch veel betere resultaten kunt bereiken. En je er een beetje in verdiepen blijkt daarbij al heel veel op te leveren. Onthoud daarbij: zie ChatGPT vooral als je digitale stagiair. Als je die zomaar ‘loslaat’, zonder duidelijke instructie, zal het resultaat waarschijnlijk tegenvallen. Maar geef je een heldere opdracht, dan word je juist vaak positief verrast!

Meer weten?

Vanwege het overweldigende succes van het seminar “De toekomst van recruitment: Hoe ChatGPT de spelregels verandert” van woensdag 29 maart organiseren wij op 28 juni het seminar 2.0. In de ochtend voor beginners, in de middag voor gevorderden. Lees er hier alles over. Of schrijf je meteen in:

Meteen inschrijvenZelf expert worden?

We zoeken bij Werf& nog een spreker en/of recruiter die het komende jaar zich namens ons helemaal wil invreten in het onderwerp. hij of zij moet zich met niets anders willen bezighouden dan met ChatGPT en (inter)nationaal recruitment. De ideale kandidaat gaat dus volledig over dit onderwerp publiceren en presenteren. Meer weten? Neem contact op met managing director Marieke Wehner.